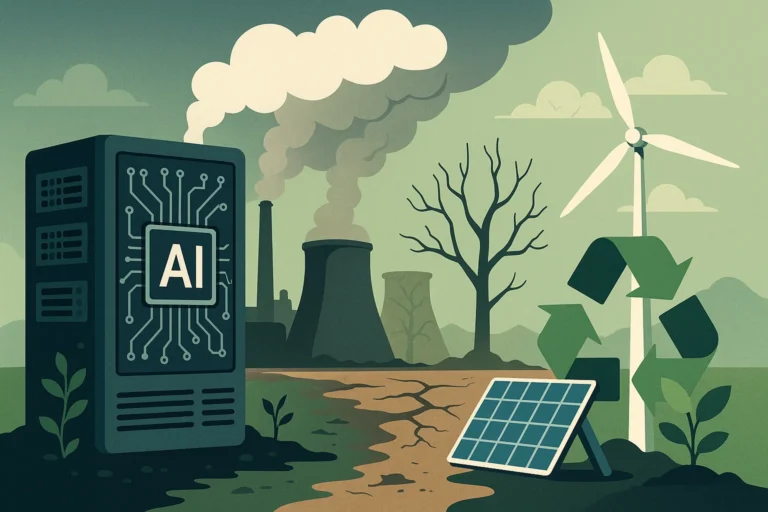

L’intelligenza artificiale sta cambiando il nostro modo di lavorare, comunicare e produrre informazioni. Ma dietro l’innovazione si nasconde un costo spesso trascurato: l’enorme fabbisogno energetico dei sistemi di calcolo.

Comprendere i veri costi dell’IA significa guardare non solo alle capacità dei programmi, ma anche al loro impatto sul pianeta e sulle risorse naturali.

Indice dei contenuti

Come funziona l’intelligenza artificiale

I programmi di IA, in particolare i Large Language Models (LLM), apprendono elaborando enormi quantità di dati. Questi sistemi analizzano testi, immagini e informazioni da internet per «imparare» schemi linguistici o visivi.

Un modello per comprendere il linguaggio naturale deve calcolare le probabilità con cui parole e frasi compaiono insieme, mentre un modello per il riconoscimento delle immagini impara a identificare oggetti e animali attraverso milioni di esempi.

Il consumo energetico nascosto dietro l’IA

Secondo il MIT, l’addestramento di GPT-4 ha richiesto energia pari a quella consumata dalla città di San Francisco in tre giorni. Ma il consumo più significativo arriva con l’uso quotidiano dei sistemi: ogni domanda inviata da un utente viene processata in grandi data center, generando calcoli complessi che richiedono ingenti quantità di energia.

Le stime indicano che già entro il 2026 l’energia necessaria ai programmi di IA potrebbe superare i consumi attuali dell’intera Russia. Per far fronte a questa domanda, alcune aziende stanno puntando allo sviluppo di centrali nucleari di nuova generazione.

Impatto ambientale e gestione delle risorse

I grandi server non solo consumano energia, ma generano anche calore, spesso smaltito tramite sistemi di raffreddamento ad acqua che sottraggono risorse agli usi civili. L’impatto ambientale è quindi significativo, ma non inevitabile. Soluzioni come i Small Language Models (SLM) consentono di ridurre i consumi, poiché funzionano direttamente sui dispositivi degli utenti senza necessità di collegamento continuo ai data center.

Oltre a contenere l’uso energetico, questi modelli minori migliorano la privacy, limitando la condivisione dei dati in rete. Il compromesso è che gli SLM svolgono compiti più limitati rispetto ai LLM, ma spesso le esigenze reali degli utenti non richiedono tutta la potenza dei grandi modelli.

Verso un’IA più sostenibile

La vera sfida dei prossimi anni sarà amministrare saggiamente l’energia disponibile e ridurre l’impatto ambientale dell’intelligenza artificiale. L’innovazione non deve essere fine a se stessa: deve integrare sostenibilità, efficienza e responsabilità. Solo così i benefici dell’IA potranno accompagnarsi a un futuro più verde e consapevole.